Um número surpreendente de vídeos está disponível na Web, abrangendo uma variedade de conteúdos, desde momentos cotidianos que as pessoas compartilham até momentos históricos e observações científicas, cada um dos quais contém um registro único do mundo. As ferramentas certas poderiam ajudar os pesquisadores a analisar esses vídeos, transformando a forma como entendemos o mundo que nos rodeia.

Os vídeos oferecem conteúdo visual dinâmico muito mais rico do que imagens estáticas, capturando movimentos, mudanças e relações dinâmicas entre entidades. Analisar esta complexidade, juntamente com a imensa diversidade de dados de vídeo disponíveis publicamente, exige modelos que vão além da compreensão tradicional de imagens. Consequentemente, muitas das abordagens que melhor funcionam na compreensão de vídeo ainda dependem de modelos especializados feitos sob medida para tarefas específicas.

Recentemente, houve um progresso emocionante nesta área usando modelos de base de vídeo (ViFMs), como VideoCLIP , InternVideo , VideoCoCa e UMT . No entanto, construir um ViFM que lide com a grande diversidade de dados de vídeo continua a ser um desafio.

Com o objetivo de construir um modelo único para compreensão de vídeo de uso geral, apresentamos “ VideoPrism: A Foundational Visual Encoder for Video Understanding ”. VideoPrism é um ViFM projetado para lidar com uma ampla gama de tarefas de compreensão de vídeo, incluindo classificação, localização, recuperação, legendagem e resposta a perguntas (QA).

Propomos inovações tanto nos dados de pré-treinamento quanto na estratégia de modelagem. Pré-treinamos o VideoPrism em um conjunto de dados enorme e diversificado: 36 milhões de pares de vídeo-texto de alta qualidade e 582 milhões de videoclipes com texto paralelo barulhento ou gerado por máquina.

Nossa abordagem de pré-treinamento foi projetada para esses dados híbridos, para aprender tanto com pares de vídeo-texto quanto com os próprios vídeos. VideoPrism é incrivelmente fácil de se adaptar a novos desafios de compreensão de vídeo e atinge desempenho de última geração usando um único modelo congelado.

| VideoPrism é um codificador de vídeo de uso geral que permite resultados de última geração em um amplo espectro de tarefas de compreensão de vídeo, incluindo classificação, localização, recuperação, legendagem e resposta a perguntas, produzindo representações de vídeo a partir de um único modelo congelado. |

Dados pré-treinamento

Um ViFM poderoso precisa de uma coleção muito grande de vídeos para treinar – semelhante a outros modelos básicos (FMs), como aqueles para modelos de linguagem grandes (LLMs). Idealmente, gostaríamos que os dados de pré-treinamento fossem uma amostra representativa de todos os vídeos do mundo. Embora naturalmente a maioria desses vídeos não tenha legendas ou descrições perfeitas, mesmo textos imperfeitos podem fornecer informações úteis sobre o conteúdo semântico do vídeo.

Para dar ao nosso modelo o melhor ponto de partida possível, reunimos um enorme corpus de pré-treinamento que consiste em vários conjuntos de dados públicos e privados, incluindo YT-Temporal-180M , InternVid , VideoCC , WTS-70M , etc. vídeos com legendas de alta qualidade, juntamente com 582 milhões de clipes adicionais com níveis variados de texto barulhento (como transcrições geradas automaticamente).

|

| Estatísticas sobre os dados de pré-treinamento de videotexto. As grandes variações nas pontuações de similaridade do CLIP (quanto maior, melhor) demonstram a qualidade diversificada da legenda dos nossos dados de pré-treinamento, que é um subproduto das várias formas usadas para coletar o texto. |

Treinamento em duas etapas

A arquitetura do modelo VideoPrism deriva do transformador de visão padrão (ViT) com um design fatorado que codifica sequencialmente informações espaciais e temporais seguindo o ViViT . Nossa abordagem de treinamento aproveita os dados de texto de vídeo de alta qualidade e os dados de vídeo com texto ruidoso mencionados acima. Para começar, usamos a aprendizagem contrastiva (uma abordagem que minimiza a distância entre pares de vídeo-texto positivos enquanto maximiza a distância entre pares de vídeo-texto negativos) para ensinar nosso modelo a combinar vídeos com suas próprias descrições de texto, incluindo as imperfeitas. Isso cria uma base para combinar o conteúdo da linguagem semântica com o conteúdo visual.

Após o treinamento contrastivo vídeo-texto, aproveitamos a coleta de vídeos sem descrições textuais. Aqui, desenvolvemos a estrutura de modelagem de vídeo mascarado para prever patches mascarados em um vídeo, com algumas melhorias. Treinamos o modelo para prever a incorporação global em nível de vídeo e a incorporação de tokens do modelo de primeiro estágio para aproveitar efetivamente o conhecimento adquirido nesse estágio. Em seguida, embaralhamos aleatoriamente os tokens previstos para evitar que o modelo aprenda atalhos.

O que há de único na configuração do VideoPrism é que usamos dois sinais complementares de pré-treinamento: descrições de texto e o conteúdo visual de um vídeo. As descrições de texto geralmente se concentram na aparência das coisas, enquanto o conteúdo do vídeo fornece informações sobre movimento e dinâmica visual. Isso permite que o VideoPrism se destaque em tarefas que exigem compreensão da aparência e do movimento.

Resultados

Conduzimos avaliações extensivas do VideoPrism em quatro categorias amplas de tarefas de compreensão de vídeo, incluindo classificação e localização de vídeo, recuperação de texto de vídeo, legendagem de vídeo, resposta a perguntas e compreensão científica de vídeo. O VideoPrism alcança desempenho de última geração em 30 dos 33 benchmarks de compreensão de vídeo – todos com adaptação mínima de um único modelo congelado.

|

| VideoPrism em comparação com os FMs anteriores de melhor desempenho. |

Classificação e localização

Avaliamos o VideoPrism em um benchmark existente de compreensão de vídeo em grande escala ( VideoGLUE ), cobrindo tarefas de classificação e localização. Descobrimos que (1) o VideoPrism supera todos os outros FMs de última geração e (2) nenhum outro modelo ficou consistentemente em segundo lugar. Isso nos diz que o VideoPrism aprendeu a agrupar com eficácia uma variedade de sinais de vídeo em um codificador – desde a semântica em diferentes granularidades até dicas de aparência e movimento – e funciona bem em uma variedade de fontes de vídeo.

|

| VideoPrism supera abordagens de última geração (incluindo CLIP , VATT , InternVideo e UMT ) no benchmark de compreensão de vídeo . Neste gráfico, mostramos as diferenças de pontuação absoluta em comparação com o melhor modelo anterior para destacar as melhorias relativas do VideoPrism. Em Charades , ActivityNet , AVA e AVA-K , usamos a precisão média média (mAP) como métrica de avaliação. Nos outros conjuntos de dados, relatamos a precisão máxima. |

Combinando com LLMs

Exploramos ainda mais a combinação do VideoPrism com LLMs para desbloquear sua capacidade de lidar com várias tarefas de linguagem de vídeo. Em particular, quando combinado com um codificador de texto (seguindo LiT ) ou um decodificador de linguagem (como PaLM-2 ), o VideoPrism pode ser utilizado para recuperação de texto de vídeo, legendagem de vídeo e tarefas de controle de qualidade de vídeo. Comparamos os modelos combinados em um conjunto amplo e desafiador de benchmarks de linguagem de visão.

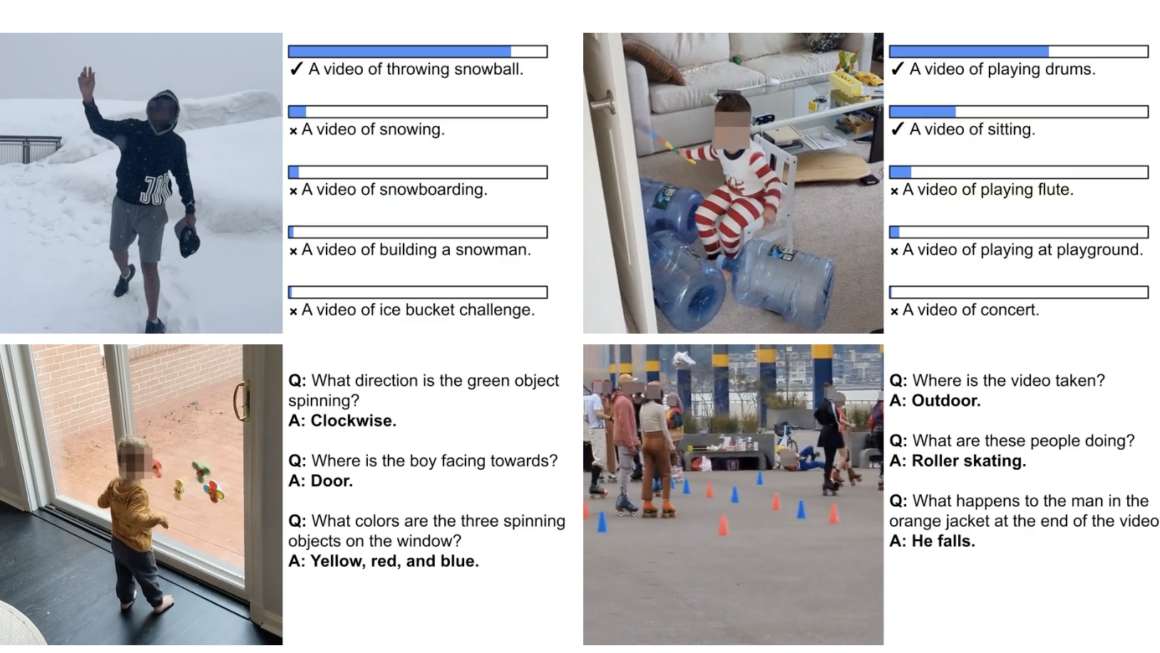

VideoPrism define o novo estado da arte na maioria dos benchmarks. A partir dos resultados visuais, descobrimos que o VideoPrism é capaz de compreender movimentos e aparências complexas em vídeos (por exemplo, o modelo pode reconhecer as diferentes cores dos objetos giratórios na janela nos exemplos visuais abaixo). Estes resultados demonstram que o VideoPrism é fortemente compatível com modelos de linguagem.

|

| VideoPrism alcança resultados competitivos em comparação com abordagens de última geração (incluindo VideoCoCa , UMT e Flamingo ) em vários benchmarks de recuperação de texto de vídeo (parte superior) e legendagem de vídeo e controle de qualidade de vídeo (parte inferior). Também mostramos as diferenças de pontuação absoluta em comparação com o melhor modelo anterior para destacar as melhorias relativas do VideoPrism. Relatamos o Recall@1 em MASRVTT , VATEX e ActivityNet , pontuação CIDEr em MSRVTT-Cap , VATEX-Cap e YouCook2 , precisão top-1 em MSRVTT-QA e MSVD-QA e índice WUPS em NExT-QA . |

| Mostramos resultados qualitativos usando VideoPrism com um codificador de texto para recuperação de vídeo-texto (primeira linha) e adaptado a um decodificador de linguagem para controle de qualidade de vídeo (segunda e terceira linhas). Para exemplos de recuperação de vídeo-texto, as barras azuis indicam as semelhanças de incorporação entre os vídeos e as consultas de texto. |

Aplicações científicas

Por fim, testamos o VideoPrism em conjuntos de dados usados por cientistas em vários domínios, incluindo áreas como etologia, neurociência comportamental e ecologia. Esses conjuntos de dados normalmente exigem conhecimento de domínio para anotar, para os quais aproveitamos os conjuntos de dados científicos existentes de código aberto da comunidade, incluindo Fly vs. Fly , CalMS21 , ChimpACT e KABR . O VideoPrism não apenas tem um desempenho excepcionalmente bom, mas também supera os modelos projetados especificamente para essas tarefas. Isso sugere que ferramentas como o VideoPrism têm o potencial de transformar a forma como os cientistas analisam dados de vídeo em diferentes campos.

Conclusão

Com o VideoPrism, apresentamos um codificador de vídeo poderoso e versátil que estabelece um novo padrão para compreensão de vídeo de uso geral. Nossa ênfase na construção de um conjunto de dados de pré-treinamento massivo e variado e em técnicas de modelagem inovadoras foi validada por meio de nossas extensas avaliações. O VideoPrism não apenas supera consistentemente as linhas de base fortes, mas sua capacidade única de generalizar o posiciona bem para lidar com uma variedade de aplicações do mundo real.

Devido ao seu amplo potencial de utilização, estamos empenhados em continuar a investigação responsável neste espaço, guiados pelos nossos Princípios de IA .

Esperamos que o VideoPrism abra caminho para avanços futuros na interseção da IA e da análise de vídeo, ajudando a concretizar o potencial dos ViFMs em domínios como descoberta científica, educação e saúde.