Todos os anos, mais de 69 milhões de pessoas em todo o mundo sofrem traumatismo crâniano, o que deixa muitos deles incapazes de se comunicar por meio de fala, digitação ou gestos.

A vida dessas pessoas poderia melhorar dramaticamente se os pesquisadores desenvolvessem uma tecnologia para linguagem de decodificação diretamente de gravações cerebrais não invasivas.

O pesquisador Jean Remi King um modelo de IA que pode decodificar a fala a partir de gravações não invasivas da atividade cerebral.

A partir de três segundos de atividade cerebral, nossos resultados mostram que nosso modelo pode decodificar os segmentos de fala correspondentes com até 73% de precisão entre os 10 primeiros a partir de um vocabulário de 793 palavras, ou seja, uma grande parte das palavras que normalmente usamos no dia-a-dia. hoje.

A decodificação da fala a partir da atividade cerebral tem sido uma meta de longa data de neurocientistas e médicos, mas a maior parte do progresso dependeu de técnicas invasivas de gravação cerebral, como eletroencefalografia estereotáxica e eletrocorticografia.

Esses dispositivos fornecem sinais mais claros que os métodos não invasivos, mas requerem intervenções neurocirúrgicas. Embora os resultados desse trabalho sugiram que a decodificação da fala a partir de gravações da atividade cerebral é viável, a decodificação da fala com abordagens não invasivas forneceria uma solução mais segura e escalável que poderia, em última análise, beneficiar muito mais pessoas.

Isto é muito desafiador, no entanto, uma vez que as gravações não invasivas são notoriamente ruidosas e podem variar muito entre sessões de gravação e indivíduos por uma variedade de razões, incluindo diferenças no cérebro de cada pessoa e onde os sensores são colocados.

Em nosso trabalho, abordamos esses desafios criando um modelo de aprendizagem profunda treinado com aprendizagem contrastiva e, em seguida, usando-o para alinhar ao máximo as gravações cerebrais não invasivas e os sons da fala. Para fazer isso, foi usado o wave2vec 2.0, um código aberto, modelo de aprendizagem autossupervisionada desenvolvido por nossa equipe FAIR em 2020.

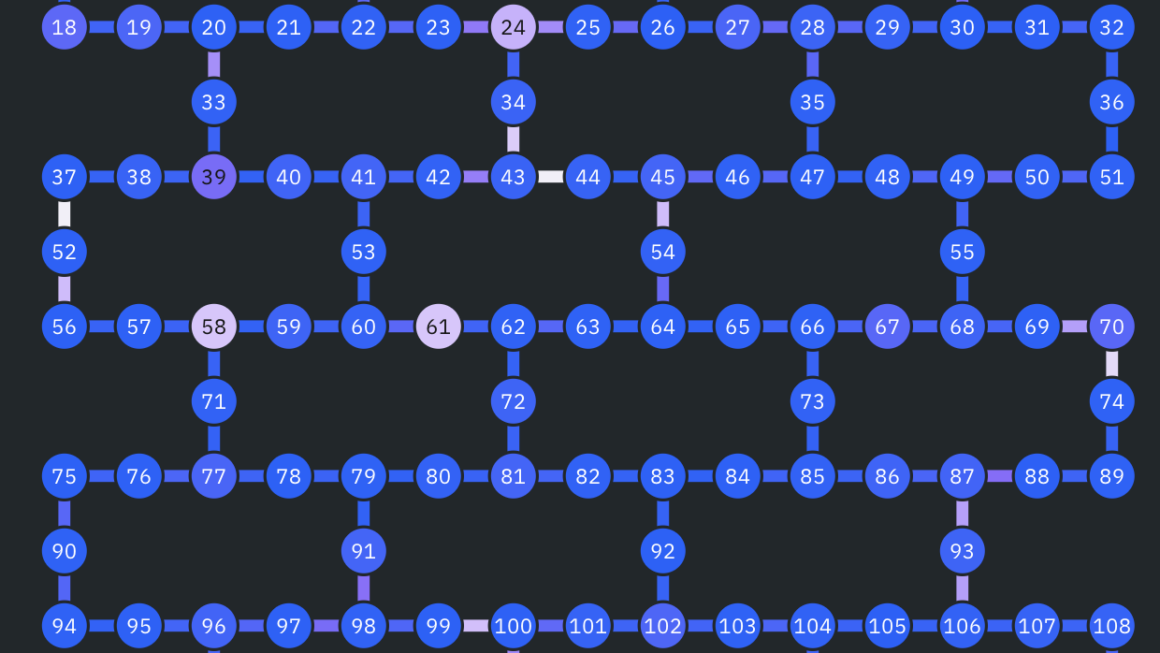

Nós nos concentramos em duas tecnologias não invasivas: eletroencefalografia e magnetoencefalografia (EEG e MEG, abreviadamente), que medem as flutuações dos campos elétricos e magnéticos provocados pela atividade neuronal, respectivamente. Na prática, ambos os sistemas podem tirar aproximadamente 1.000 instantâneos da atividade cerebral macroscópica a cada segundo, usando centenas de sensores.

Aproveitamos quatro conjuntos de dados de EEG e MEG de código aberto de instituições acadêmicas, aproveitando mais de 150 horas de gravações de 169 voluntários saudáveis ouvindo audiolivros e frases isoladas em inglês e holandês.

Em seguida, inserimos essas gravações de EEG e MEG em um modelo de “cérebro”, que consiste em uma rede convolucional profunda padrão com conexões residuais. Sabe-se que as gravações de EEG e MEG variam extensivamente entre os indivíduos devido à anatomia cerebral individual, às diferenças na localização e ao tempo das funções neurais nas regiões cerebrais e à posição dos sensores durante uma sessão de gravação.

Na prática, isso significa que a análise de dados cerebrais geralmente requer um pipeline de engenharia complexo elaborado para realinhar os sinais cerebrais em um modelo cerebral. Em estudos anteriores, decodificadores cerebrais foram treinados em um pequeno número de gravações para prever um conjunto limitado de características da fala, como categorias de classes gramaticais ou palavras de um pequeno vocabulário. Para nossa pesquisa, projetamos uma nova camada de incorporação de sujeitos, que é treinada de ponta a ponta para alinhar todas as gravações cerebrais em um espaço comum.

*Para decodificar a fala a partir de sinais cerebrais não invasivos, treinamos um modelo com aprendizagem contrastiva para alinhar a fala e sua atividade cerebral correspondente.

Para a arquitetura aprender a alinhar a saída deste modelo cerebral às representações profundas dos sons da fala que foram apresentados aos participantes foi usado o wav2vec 2.0 para mostrar que esse algoritmo de fala aprende automaticamente a gerar representações de fala que se alinham com as do cérebro.

O surgimento de representações de fala “semelhantes ao cérebro” no wav2vec 2.0 tornou a construção de nosso decodificador uma escolha natural, porque ajuda a saber quais representações devemos tentar extrair dos sinais cerebrais.

Após o treinamento, nosso sistema realiza o que é conhecido como classificação zero shot: dado um trecho de atividade cerebral, ele pode determinar, a partir de um grande conjunto de novos clipes de áudio, qual deles a pessoa realmente ouviu. A partir daí, o algoritmo infere as palavras que a pessoa provavelmente ouviu.

Este é um passo emocionante porque mostra que a IA pode aprender com sucesso a decodificar gravações não invasivas barulhentas e variáveis da atividade cerebral quando a fala é percebida. O próximo passo é ver se podemos estender este modelo para decodificar diretamente a fala da atividade cerebral sem precisar do conjunto de clipes de áudio, ou seja, avançar em direção a um decodificador de fala seguro e versátil.

Nossas análises mostram ainda que vários componentes de nosso algoritmo, incluindo o uso de wav2vec 2.0 e a camada de assunto, foram benéficos para o desempenho de decodificação. Além disso, mostramos que nosso algoritmo melhora com o número de gravações de EEG e MEG.

Na prática, isto significa que a nossa abordagem beneficia da extracção de grandes quantidades de dados heterogéneos e poderia, em princípio, ajudar a melhorar a descodificação de pequenos conjuntos de dados. Isto é importante porque, em muitos casos, pode ser difícil recolher muitos dados sobre um determinado participante.

Por exemplo, não é prático exigir que os pacientes passem dezenas de horas num scanner para verificar se o sistema funciona para eles. Em vez disso, os algoritmos poderiam ser pré-treinados em grandes conjuntos de dados, incluindo muitos indivíduos e condições, e então apoiar a decodificação da atividade cerebral para um novo paciente com poucos dados.

Usando IA para entender como o cérebro funciona

Os resultados da nossa pesquisa são encorajadores porque mostram que a IA auto-supervisionada e treinada pode decodificar com sucesso a fala percebida a partir de gravações não invasivas da atividade cerebral, apesar do ruído e da variabilidade inerentes a esses dados.

Neste trabalho, focamos na decodificação da percepção da fala, mas o objetivo final de permitir a comunicação do paciente exigirá estender este trabalho à produção da fala. Esta linha de pesquisa poderia ir além da assistência aos pacientes, incluindo potencialmente a possibilidade de novas formas de interação com computadores.

De forma mais geral, o nosso trabalho faz parte de um esforço mais amplo da comunidade científica para utilizar a IA para compreender melhor o cérebro humano. Estamos compartilhando esta pesquisa abertamente para acelerar o progresso nos desafios que ainda estão por vir. Esperamos trabalhar juntos e contribuir para a comunidade de pesquisa nesta área.